disallow feed что значит

Настраиваем файл robots.txt для WordPress

В этой статье пример оптимального, на мой взгляд, кода для файла robots.txt под WordPress, который вы можете использовать в своих сайтах.

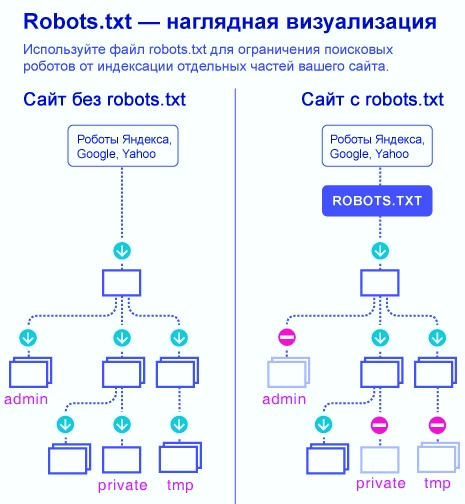

Для начала, вспомним зачем нужен robots.txt — файл robots.txt нужен исключительно для поисковых роботов, чтобы «сказать» им какие разделы/страницы сайта посещать, а какие посещать не нужно. Страницы, которые закрыты от посещения не будут попадать в индекс поисковиков (Yandex, Google и т.д.).

Таким образом, если мы закрыли страницу в robots.txt, робот просто пропустит её не сделав никаких запросов на сервер. А если мы закрыли страницу в заголовке X-Robots-Tag или мета-теге, роботу нужно сначала сделать запрос к серверу, получить ответ, посмотреть что находится в заголовке или метатеге и только потом принять решения индексировать страницу или нет.

Таким образом, файл robots.txt объясняет роботу какие страницы (URL) сайта нужно просто пропускать не делая никаких запросов. Это экономит время обхода роботом всех страниц сайта и экономит ресурсы сервера.

Рассмотрим на примере. Допустим, у нас есть сайт на котором всего 10 000 страниц (не 404 URL). Из них полезных страниц с уникальным контентом всего 3000, остальное это архивы по датам, авторам, страницы пагинации и другие страницы контент на которых дублируется (например фильтры с GET параметрами). Допустим, мы хотим закрыть от индексации эти 7000 неуникальных страниц:

Несложно догадаться, что в этом случае первый вариант гораздо предпочтительнее потому что на обход сайта робот будет тратить гораздо меньше времени, а сервер будет генерировать гораздо меньше страниц.

Оптимальный код robots.txt для WordPress

Версия 1 (не строгая)

Версия 2 (строгая)

В этом варианте мы контролируем все доступы. Сначала глобально запрещаем доступ к почти всему от WP ( Disallow: /wp- ), а затем открываем, там где нужно.

Этот код я пожалуй не рекомендовал бы, потому что тут закрывается все от wp- и нужно будет описать все что разрешено. Так в будущем, когда WP введет что-то новое, это новое может стать недоступно для роботов. Так например получилось с картой сайта WP.

Директивы (разбор кода)

Определяет для какого робота будет работать блок правил, который написан после этой строки. Тут возможны два варианта:

User-agent: * — указывает, что правила после этой строки будут работать для всех поисковых роботов.

Возможные роботы (боты) Яндекса:

Возможные роботы (боты) Google:

Запрещает роботам «ходить» по ссылкам, в которых встречается указанная подстрока:

Пример добавления нового правила. Допустим нам нужно закрыть от индексации все записи в категории news. Для этого добавляем правило:

Оно запретить роботам ходить по ссылками такого вида:

Подробнее изучить директивы robots.txt вы можете на странице помощи Яндекса. Имейте ввиду, что не все правила, которые описаны там, работают для Google.

ВАЖНО о кириллице: роботы не понимают кириллицу, её им нужно предоставлять в кодированном виде. Например:

ВАЖНО: Сортировка правил

Yandex и Google обрабатывает директивы Allow и Disallow не по порядку в котором они указаны, а сначала сортирует их от короткого правила к длинному, а затем обрабатывает последнее подходящее правило:

будет прочитана как:

Чтобы быстро понять и применять особенность сортировки, запомните такое правило: «чем длиннее правило, тем больший приоритет оно имеет. Если длина правил одинаковая, то приоритет отдается директиве Allow.»

Проверка robots.txt и документация

Проверить правильно ли работают правила можно по следующим ссылкам:

Google: https://www.google.com/webmasters/tools/robots-testing-tool Нужна авторизация и наличия сайта в панели веб-мастера.

robots.txt в WordPress

Изменить содержание robots.txt можно через:

Рассмотрим как использовать оба хука.

robots_txt

По умолчанию WP 5.5 создает следующий контент для страницы /robots.txt :

В результате перейдем на страницу /robots.txt и видим:

Обратите внимание, что мы дополнили родные данные ВП, а не заменили их.

do_robotstxt

Теперь, пройдя по ссылке http://site.com/robots.txt увидим:

Рекомендации

Не рекомендуется исключать фиды: Disallow: */feed

Потому что наличие открытых фидов требуется, например, для Яндекс Дзен, когда нужно подключить сайт к каналу (спасибо комментатору «Цифровой»). Возможно открытые фиды нужны где-то еще.

Фиды имеют свой формат в заголовках ответа, благодаря которому поисковики понимают что это не HTML страница, а фид и, очевидно, обрабатывают его иначе.

Ошибочные рекомендации

Закрывать страницы тегов и категорий

Если ваш сайт действительно имеет такую структуру, что на этих страницах контент дублируется и в них нет особой ценности, то лучше закрыть. Однако нередко продвижение ресурса осуществляется в том числе за счет страниц категорий и тегирования. В этом случае можно потерять часть трафика

Прописать Crawl-Delay

Модное правило. Однако его нужно указывать только тогда, когда действительно есть необходимость ограничить посещение роботами вашего сайта. Если сайт небольшой и посещения не создают значительной нагрузки на сервер, то ограничивать время «чтобы было» будет не самой разумной затеей.

Спорные рекомендации

Открыть папку uploads только для Googlebot-Image и YandexImages

Совет достаточно сомнительный, т.к. для ранжирования страницы необходима информация о том, какие изображения и файлы на ней размещены.

Нестандартные Директивы

Clean-param

Google не понимаю эту директиву. Указывает роботу, что URL страницы содержит GET-параметры, которые не нужно учитывать при индексировании. Такими параметрами могут быть идентификаторы сессий, пользователей, метки UTM, т.е. все то что не влияет на содержимое страницы.

Заполняйте директиву Clean-param максимально полно и поддерживайте ее актуальность. Новый параметр, не влияющий на контент страницы, может привести к появлению страниц-дублей, которые не должны попасть в поиск. Из-за большого количества таких страниц робот медленнее обходит сайт. А значит, важные изменения дольше не попадут в результаты поиска. Робот Яндекса, используя эту директиву, не будет многократно перезагружать дублирующуюся информацию. Таким образом, увеличится эффективность обхода вашего сайта, снизится нагрузка на сервер.

Например, на сайте есть страницы, в которых параметр ref используется только для того, чтобы отследить с какого ресурса был сделан запрос и не меняет содержимое, по всем трем адресам будет показана одна и та же страница:

Если указать директиву следующим образом:

то робот Яндекса сведет все адреса страницы к одному:

Пример очистки нескольких параметров сразу: ref и sort :

Crawl-delay (устарела)

Google не понимает эту директиву. Таймаут его роботам можно указать в панели вебмастера.

Яндекс перестал учитывать Crawl-delay

Проанализировав письма за последние два года в нашу поддержку по вопросам индексирования, мы выяснили, что одной из основных причин медленного скачивания документов является неправильно настроенная директива Crawl-delay в robots.txt […] Для того чтобы владельцам сайтов не пришлось больше об этом беспокоиться и чтобы все действительно нужные страницы сайтов появлялись и обновлялись в поиске быстро, мы решили отказаться от учёта директивы Crawl-delay.

Для чего была нужна директива Crawl-delay

Host (устарела)

Заключение

Важно помнить, что изменения в robots.txt на уже рабочем сайте будут заметны только спустя несколько месяцев (2-3 месяца).

На сервисе avi1.ru Вы можете уже сейчас приобрести продвижение SMM более чем в 7 самых популярных социальных сетях. При этом обратите внимание на достаточно низкую стоимость всех услуг сайта.

Disallow feed что значит

AliExpress Россия увеличила свои логистические мощности в 4 раза

Как получать ссылки с образовательных сайтов

В robots.txt числится вот такая запись: Disallow: /*?. Она часом не означает исключить все страницы кроме главной?

И посмотрите пожалуйста, нет здесь ничего лишнего:

Я так понимаю CMS WordPress? Запись эта просто закрывает от индексации страницы с результатами поиска на сайте!

Да, это WP поиск закрыт.

Так проще и понятнее 🙂

я как бы «академически» завернул

Понятно, но у меня указано:

Но пришлось доп. прописать:

Ссылки на ответ в комментариях вроде индексирует и создаёт дубли страниц:

это вообще бредовая запись

предыдущее правило (/?*) закрывает и эти страницы /?replytocom=

angr Спасибо, робот.тхт не знаю.

User-agent: *

Disallow: /redirect/

Disallow: /author/

Disallow: /author*

Disallow: /wp-admin/

Disallow: /wp-includes

Disallow: /?s=

Disallow: /xmlrpc.php

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: */comments

Disallow: */comment-page*

Disallow: /comments/

Disallow: /comments/feed/

Disallow: /*trackback

Disallow: /*?

Disallow: /?*

Disallow: /*feed

Disallow: */feed

Disallow: /feed

Disallow: /feeds

Disallow: /feeds/

Disallow: /feed/

Disallow: /?feed=

Disallow: */trackback

Disallow: /?replytocom=

# Google AdSense

User-agent: Mediapartners-Google*

Disallow:

Allow: /*

Как настроить файл robots.txt для WordPress? Две версии файла

Файл robots.txt необходим роботам поисковых систем, чтобы они могли понять, какие страницы и разделы сайта следует посещать и включать в индекс, а какие – не нужно. Запрещенные для посещения поисковыми ботами страницы не будут индексироваться и появляться в выдаче Яндекса, Google и прочих поисковиков.

Вот наглядный пример того, в чем разница между веб-ресурсом, у которого настроен файл robots, и сайтом без него:

В данной статье я расскажу о нескольких способах правильной настройки robots.txt для популярного движка WordPress.

Оптимальный код файла для WordPress

Важно! Не забудьте поменять “https://domain.ru/sitemap.xml” на свой пусть к файлу sitemap.

Теперь разберем, какие директивы в коде что означают:

1. Директива User-agent: * означает, что все правила, описанные ниже нее, касаются всех роботов поисковых систем. Если вы хотите прописать правила для одного определенного бота, вместо * нужно ввести его имя. Например:

2. Строка Allow: /uploads указывается, чтобы разрешить ботам вносить в индекс страницы, где присутствует /uploads. Нужно обязательно указать данное правило, потому что выше запрещены к индексированию страницы, которые начинаются с /wp-, а проблема в том, что /uploads присутствует в /wp-content/uploads.

Команда Allow: /uploads нужна для перебивания правила Disallow: /wp-, так как по ссылкам типа /wp-content/uploads/ могут располагаться изображения, важные для индексации. Помимо картинок есть вероятность присутствия прочих файлов, которые нет нужды запрещать включать в поиск. Строчку Allow допускается прописывать и до, и после Disallow.

3. Директивы Disallow: запрещают ботам переходить по ссылкам, начинающимся с:

4. Строчка Sitemap: http://domain.ru/sitemap.xml сообщает поисковому боту о XML файле с картой сайта. Если на вашем ресурсе присутствует данный файл, укажите к нему полный путь. Если их несколько, нужно прописать путь отдельно к каждому из них.

Рекомендуется не закрывать от индексации фиды: Disallow: /feed.

У фидов собственный формат в заголовках ответа, что позволяет поисковым системам понять, что это фид, а не HTML документ, и обрабатывать его по-другому.

А если вы не хотите передавать RSS, чтобы например у вас не воровали через него контент, то тогда надежнее отключить его с помощью специальных плагинов, например Disable Feeds.

Сортировка правил перед обработкой

Google и Яндекс обрабатывают правила Disallow и Allow без соблюдения порядка, в котором они прописаны в robots.txt. Поисковики сортируют директивы от коротких к длинным, после чего обрабатывают последнюю подходящую директиву.

Например, данная инструкция:

Поисковые системы обработают следующим образом:

В случае проверки ссылки типа /wp-content/uploads/file.jpg, директива Disallow сначала запретит ссылку с /wp-, а затем Allow разрешит ее индексировать, поэтому ссылка будет доступна для роботов.

На заметку. Запомните главное при сортировке правил: чем директива в файле robots.txt длиннее, тем она приоритетнее. Когда директивы одинаковой длины, приоритетной становится Allow.

Стандартный файл robots для WordPress

Хотя первый метод является более современным и логичным, но я все же пользуюсь вторым файлом robots.txt. Потому что мне так спокойнее, что с помощью директивы Dissalow: /wp- я не запрещу что то нужное, поэтому я прописываю каждую папку отдельно.

Исходя из вышеперечисленных правок, у меня получается вот такой robots.txt:

Важно! Не забудьте поменять “https://domain.ru/sitemap.xml” на свой пусть к файлу sitemap.

Доработка файла под свои цели

Если потребуется заблокировать еще какие-то страницы или разделы веб-ресурса, добавьте директиву Disallow. К примеру, желая скрыть от роботов все публикации в рубрике News, пропишите правило:

Так вы запретите ботам переходить по ссылкам типа http://domain.ru/news и закроете от индексации такие страницы:

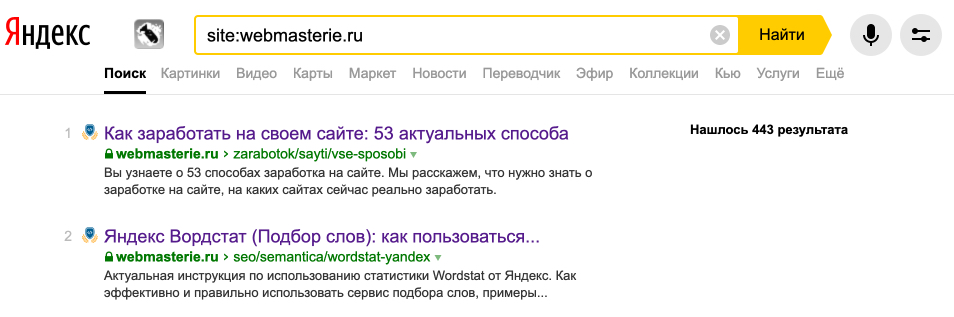

Постоянно проверяйте, какие страницы проиндексированы поисковыми системами и находятся в выдаче. Сделать это можно с помощью оператора site:domain.ru.

И если заметили мусорные, ненужные страницы, то блокируйте их в robots.txt.

Проверка файла и документация

Проверить корректность директив, прописанных в robots.txt, вы можете по ссылкам:

Динамический robots.txt

В CMS Вордпресс обработка запроса на файл robots производится отдельно. Вебмастеру нет нужды самостоятельно создавать в корневом каталоге сайта файл robots. Это не то что можно не делать, но и нужно, иначе плагины не смогут изменять созданный вебмастером файл, когда в этом появится необходимость.

Для изменения содержания динамического robots налету, через хук do_robotstxt, добавьте данный код в файл funtcions.php:

При переходе по ссылке http://example.com/robots.txt вы увидите следующий код:

Заключение

Обязательно следите за актуальностью своего robots.txt. Проверяйте страницы на индексацию, чтобы там не было мусорных, не нужных страниц. Если такие заметили, то блокируйте их. При внесении изменений в файл robots.txt для уже рабочего веб-сайта результат будет видно не раньше, чем через 2-3 месяца.

Я всегда стараюсь следить за актуальностью информации на сайте, но могу пропустить ошибки, поэтому буду благодарен, если вы на них укажете. Если вы нашли ошибку или опечатку в тексте, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

Правильный Robots.txt для WordPress 2021 — подробная настройка

Одной из важнейших вещей при создании и оптимизации сайта для поисковых систем считают Robots.txt. Небольшой файлик, где прописаны правила индексирования для поисковых роботов.

Если файл будет настроен неправильно, то сайт может неправильно индексироваться и терять большие доли трафика. Грамотная настройка наоборот позволяет улучшить SEO, и вывести ресурс в топы.

Сегодня мы поговорим о настройке Robots.txt для WordPress. Я покажу вам правильный вариант, который сам использую для своих проектов.

Что такое Robots.txt

Как я уже и сказал, robots.txt — текстовой файлик, где прописаны правила для поисковых систем. Стандартный robots.txt для WordPress выглядит следующим образом:

Именно в таком виде он создается плагином Yoast SEO. Некоторые считают, что этого хватит для правильной индексации. Я же считаю, что нужна более детальная проработка. А если речь идет о нестандартных проектах, то проработка нужна и подавно. Давайте разберемся в основных директивах:

В принципе, ничего сложного. Дам дополнительные пояснения по директивам Clean-param (откройте вкладку).

Параметры, как правило, используются на динамических сайтах. Они могут передавать поисковым системам лишнюю информацию — создавать дубли. Чтобы избежать этого, мы должны указать в Robots.txt директиву Clean-param с указанием параметра и ссылки, к которой это параметр применяется.

В нашем примере site.ru/statia?uid=32 — site.ru/statia — ссылка, а все, что после знака вопроса — параметр. Здесь это uid=32. Он динамический, и это значит, что параметр uid может принимать другие значения.

Например, uid=33, uid=34…uid=123434. В теории их может быть сколько угодно, поэтому мы должны закрыть от индексации все параметры uid. Для этого директива должна принять такой вид:

Более подробно о том, что такое Robots.txt можно узнать из Яндекс.Помощи. Или из этого видеоролика:

Базовый Robots.txt для WordPress

Совсем недавно я приобрел плагин Clearfy Pro для своих проектов. Там очень много разных функций, и одна из них — создание идеального Robots.txt. На самом деле насколько он идеален — я не знаю, вебмастера расходятся во мнениях.

Кто-то предпочитает делать более краткие версии роботса, указывая правила для всех поисковых систем сразу. Другие прописывают отдельные правила для каждого поисковика (в основном для Яндекса и Гугла).

Что из этого правильно — точно сказать не могу. Однако я предлагаю вам ознакомиться с базовой версией Robots.txt для WordPress от Clearfy Pro. Я немного подредактировал ее — указал директиву Sitemap. Удалил директиву Host.

Не могу сказать, что это лучший вариант для блогов на ВП. Но во всяком случае, он лучше, чем то, что нам предлагает Yoast SEO по умолчанию.

Расширенный Robots.txt для WordPress

Теперь посмотрим на расширенную версию Robots.txt для WordPress. Наверняка вы знаете, что все сайты на WP имеют одинаковую структуру. Одинаковые названия папок, файлов и т.д. позволяют специалистам выявить наиболее приемлемый вариант роботса.

В этой статье я хочу представить вам свой вариант Robots.txt. Его я использую как для своих сайтов, так и для клиентских. Вы могли видеть такой вариант и на других сайтах, т.к. он обладает некоторой популярностью.

Итак, правильный Robots.txt для WordPress выглядит следующим образом:

Ранее в Robots.txt использовалась директива Host. Она указывала главное зеркало сайта. Теперь это делается при помощи редиректа. Подробнее об этом можно почитать в блоге Яндекса.

Комментарии (текст после #) можно удалить. Указываю Sitemap с https протоколом, т.к. большинство сайтов сейчас используют защищенное соединение. Если у вас нет SSL, то измените протокол на http.

Обратите внимание на то, что я закрываю метки (теги). Делаю это потому, что они создают большое количество дублей. Это плохо сказывается на SEO, но если вы хотите открыть метки, тогда уберите строчку disallow: /tag/ из файла.

Заключение

В общем-то, вот так выглядит правильный Robots.txt для WordPress. Смело копируйте данные в файл и пользуйтесь. Отмечу, что этот вариант подходит только для стандартных информационных сайтов.

В других ситуациях может потребоваться индивидуальная проработка. На этом все. Спасибо за внимание. Буду благодарен, если вы подпишитесь на мой телеграм-канал и мою группу ВК.

Интернет-предприниматель и создатель этого блога. Бросил универ, работаю удаленно и развиваю бизнес в интернете с 2017-го года.

Основные способы заработка: сайты, арбитраж трафика, партнерские программы, фриланс. Сейчас присматриваюсь к офлайн-бизнесу.

Увлекаюсь инвестированием, видеоиграми, хожу в фитнес-клуб.

Добавляйте блог в закладки и почаще заглядывайте, буду очень рад 😊.

А зачем ставить # в начале строчки, если она просто не нужна?)

Только вес файла будет увеличивать, хоть и очень-очень незначительно.

Если оставить все, как в моем варианте — теги не будут индексироваться ПС.

У себя на сайте я использую их чисто для внутренней навигации. Считаю, что в поисковой выдаче они будут лишними — создают дубли.

Но если у вас другое мнение, то можете просто убрать эти строчки из файла.

А зачем хост удалять?

Куча гайдов и кто во что горазд, думаю оставить минималку и вообще там не ковыряться.. я не опытный ещё)

Раньше Хост держали только для Яндекса. Потом они выкатили апдейт своих алгоритмов, и сообщили, что теперь главное зеркало будет учитываться через редирект. Короче говоря, теперь это строка вообще не воспринимается поисковыми системами — то есть лишняя.

Вы можете оставить ее, но она бесполезная.

Здравствуйте! А что нужно сделать, чтобы всё правильно работало, где и как этот редирект настроить?

К стати, если у тебя скопировать и вставить, то вон какая каша получается, не правильно ты как-то список залил..

Посмотри: (ссылка удалена)

Спасибо за замечание! Плагин для антиплагиата, который добавлял ссылку в конец скопированного текста мешал все в кашу. Сейчас отключил, можно копировать — все будет в нормальном виде.

Здравствуйте. Закрываются ссылки так же, как и все остальные.

Здравствуйте, копировать и вставить весь код для робота?

Здравствуйте, а Host прописывать не надо?

Не надо, сейчас от него отказались все популярные поисковики.

Спасибо за статью. Мучаюсь с метками — попадают в поиск. Оказалось неправильно закрыл в роботсе.

Рад, что статья вам помогла. Метки можно закрыть не только при помощи Роботса, но и через Yoast SEO)

что думаете по поводу

Disallow: */print/

Disallow: *?print=*

Первый закроет все ссылки, которые заканчиваются на /print/

Второй закроет все ссылки, в которых есть параметр *?print=* с любым содержанием.

Добрый день! А чем вам не нравится Robots.txt от Clearfy Pro? Там ведь в плагине все лишнее можно закрыть, вот оно и не прописывается лишний раз в Robots.txt, да и уверяют они, что это лучший выбор. Вы как считаете?

У них слишком короткий вариант «сразу для всех ПС». Конкретно мне такое не подходит, потому что для Яндекса нужно открывать турбо-страницы. Для Гугла их открывать не нужно 🙂

И еще: я считаю, что проработка файла под каждую поисковую систему лучше скажется на SEO.

Но вы можете поставить вариант Clearfy, с этим нет никаких проблем) Не думаю, что будет слишком большая разница.

Добрый день! Проверил ваш инструмент, какой-то он мутный. Не думаю, что его рекомендациям стоит следовать. Но это мое мнение, вы можете попробовать сделать вариант, который будет «проходить» в этом инструменте без ошибок.

Лично я бы советовал проверять Robots на ошибки через официальные инструменты — Яндекс.Вебмастер и Search Console.

PS Ваш инструмент показывает не ошибки, а предупреждения. И там их всего два вида: ошибка шаблонов (когда указываются не адреса, а шаблоны адресов) — инструмент не считает это «оптимальной практикой»; директива Allow, которая стоит после директивы Disallow. Можете поставить сначала Allow, а уже потом Disallow — возможно инструмент не будет выдавать ошибку. Из-за кривого перевода я не особо понял, что инструмент конкретно требует + он рассматривает только Google и Bing, что уже наводит на определенные мысли)

Здравствуйте! Вопрос по последней строчке – Sitemap: site.com/sitemap_index.xml #

Почему карта сайта файлом «sitemap_index.xml»? У меня называется файл просто «sitemap.xml». Мне как нужно файл прописывать с «_index» или как есть (sitemap.xml).

Извините, может, вопрос глупый. Я только учусь. Буду благодарна за ответ.

Если ваша карта называется Sitemap.xml, то вы должны вставить в Роботс: вашдомен.ру/sitemap.xml — как есть. Я поставил такой вариант, т. к. подавляющее большинство использует плагин Yoast SEO и XML-карту сайта от него.

А вопрос совсем не глупый, все мы были новичками =).

Спасибо за ответ! Как ни странно, но я тоже использую плагин Yoast SEO)). А карту сайта я создала вручную и назвав Sitemap.xml, положила в корень. И в яндекс-вебмастер и гугл серч консоле прописала дорогу к ней.

После вашего ответа проверила, действительно 2 карты теперь есть и Sitemap.xml и sitemap_index.xml. Только sitemap_index.xml какая-то странная, из 8 пунктов. Теперь не знаю, что делать. Может, имеет смысл удалить сделанную мной Sitemap.xml? Не возникает ли путанница у поисковиков из-за того, что у меня 2 карты активны?

Надеюсь, понятно все изложила. Спасибо большое за ваш ответы! Для меня это очень ценно.

Лучше использовать одну карту сайта. Можете либо удалить sitemap.xml, оставив карту от Yoast, либо отключить карту от Yoast и оставить созданную вами.

Yoast SEO создает несколько карт сайта. Sitemap_index — это такой список всех карт сайта (отдельно карта для постов, отдельно для страниц, отдельно для тегов и т. д.). Поисковые системы отлично понимают этот принцип работы. Они заходят в sitemap_index, видят там ссылки на другие карты сайта и индексируют их.

Кстати, советую вам глянуть эту статью про Sitemap.xml. В ней я описываю наиболее популярные способы создания карты сайта.

Так и сделаю — удалю одну карту. Спасибо за такой исчерпывающий ответ, поняла почему Sitemap_index странно выглядит на первый взгляд. Статью обязательно прочитаю.

Вы предлагаете закрывать довольно много. Но я тут недавно читал, что самый лучший вариант роботса это тот, который не закрывает доступ практически вообще. Что скажите по этому поводу? Если закрыть только админку — достаточно ли этого будет?

Слышал про ваш вариант. Можете попробовать, но я считаю, что более тщательная проработка файла лучше скажется на SEO.

Ваш вариант, кстати, возможно применим для Гугла. Яндекс же в любом случае будет накладывать санкции за плохо проработанный файл — слишком много мусорных страниц попадет в поиск и это, в общем, плохо скажется на продвижении.

Да, гугл ругается, потому что не использует такой синтаксис. Можно забить. Прописан он правильно, можете проверить на ошибки в Яндекс.Вебмастере)

По поводу удаления — если вам так режет глаза, то можно удалить. Эта строка просто чисти UTM-метки (так рекомендует делать сам Яндекс). Для гугла эти UTM-метки просто закрываются.

ок, спасибо 🙂 надеюсь на лучшее.

Символ # отвечает за комментарии для пользователей и обычно эти комментарии удаляются из Роботса, чтобы лишний раз не нагружать файл. Обычно комментарий выглядит так: «# Какой-то комментарий». То есть с пробелом.

Попробуйте добавить вашу запись (Disallow: /*#comment-*) и проверить Роботс через Яндекс.Вебмастер. Добавьте запись в Роботс, зайдите в ЯВМ, раздел «Инструменты» — «Анализ robots.txt» и проверьте доступность этих ссылок-дубликатов.

Было бы замечательно, если бы в статье было разъяснение для чего нужно закрывать некоторые папки. В частности меня интересуют папки /cgi-bin и /wp-

# Что скажите про мой роботс.тхт от плагина All in One SEO Pack:

User-agent: Yandex

Allow: /yandex/news/ # установлен плагин Yandex.News Feed by Teplitsa

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php # вордпресс рекомендует индексировать

User-agent: Yandex

Disallow: /*wp-admin* # админ

Disallow: /*wp-includes* # папки и подпапки includes

Disallow: /*plugins* # папки и подпапки плагина

Disallow: /*cache* # папки и подпапки кеша

Disallow: /*author* # нашел в яндекс метрики на страницы входа

Disallow: /*?fbclid=* # страницы поиска от темы кассандра

Disallow: /*?_gl=* # нашел в яндекс метрики на страницы входа

Disallow: /*?amp* # установлен плагин AMP нашел в яндекс метрики на страницы входа

Disallow: /*?s=* # страница поиска от вордпресс

Allow: /*.css* # css файлы

Allow: /*.js* # ява скрипты

Allow: /*uploads* # папку и подпапки фотографий

User-agent: YandexDirect

Allow: / # разрешил рекламу от яндекс директ

Зачем два раза User-Agent: Yandex? — код с открытием фида нужно поместить после «Allow: /*uploads* # папку и подпапки фотографий»

Плагин All in One SEO Pack сразу же после активации его блока роботс.тхт прописал вот так (см. ниже) и изменить эту запись уже невозможно.

User-agent: Yandex

Allow: /yandex/news/

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Когда прописываю Disallow и Allow: в User-agent: * это как мы знаем для всех ботов при проверке в Яндекс вебмастере где есть инструмент Анализ robots.txt, выходит ошибка. Если прописать Disallow и Allow: в User-agent: Yandex, как в примере (см. выше) то ошибку не выдает. И также плагин All in One SEO Pack не позволяет прописать рекомендации Disallow и Allow: отдельно дважды для каждого поисковика User-agent: * и User-agent: Yandex. То есть дважды не разрешает плагин повторять рекомендации Disallow и Allow. По-моему, поисковик Гугла не индексирует «мусорные» повторяющиеся с одинаковым контентом, но с разными url страницы и не учитывает запреты Disallow: в роботс.тхт. Выходит роботу Гугла все равно ставите вы запреты или нет, а робот Яндекса учитывает роботс.тхт. В Яндекс метрики где «страницы входа» у меня на сайтах есть мусорные страницы и их нужно закрывать, что я и проделал (см. выше) пример моего роботс. тхт. У меня возникает вопрос, стоит ли прописать рекомендации только в User-agent: * и, игнорировать ошибку в Яндекс инструменте Анализ robots.txt либо оставить мой роботс.тхт, как есть (см. выше) в комментарии?

Спасибо. Но у меня гугл ругается на то, что в Роботс закрыт фид: Disallow: /feed

Search Console has identified that your site is affected by 1 Coverage issues:

Top Warnings

Вот скрин (ссылка удалена)

Так что, получается открывать фид в роботс?