disallow search что значит

Как составить правильный robots.txt для Яндекса и Google [инструкция]

Примеры готового файла robots.txt. Решения для сайтов на WordPress, Битрикс, OpenCart и Joomla.

Вебмастер может направить поисковых ботов на страницы, которые считает обязательными для индексирования, и скрыть те, которых в выдаче быть не должно. Для этого предназначен файл robots.txt. Команда сервиса для анализа сайта PR-CY составила гайд об этом файле: для чего он нужен, из каких команд состоит, как составить его по правилам и проверить.

Зачем нужен robots.txt

С помощью этого файла можно повлиять на поведение ботов Яндекса и Google. Файл robots.txt содержит указания для краулеров, предназначенных для индексирования сайта. Он состоит из списка команд, которые рекомендуют либо просканировать, либо пропустить конкретные страницы или целые разделы сайта. Если боты «прислушаются» к этим пожеланиям, то не будут посещать закрытые страницы или индексировать определенный тип контента.

Закрывают обычно дублирующие страницы, служебные, неинформативные, страницы с GET-параметрами или просто неважные для пользователей.

Как надежно закрыть страницу от ботов

Поисковики не воспринимают robots.txt как список жестких правил, это только рекомендации. Даже если в robots стоит запрет, страница может появиться в выдаче, если на нее ведет внешняя или внутренняя ссылка.

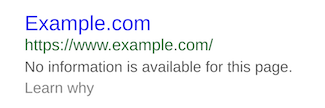

Страница, доступ к которой запретили только в robots.txt, может попасть в выдачу и будет выглядеть так:

Если вы точно не хотите, чтобы страница попала в индекс, недостаточно запретить сканирование в файле robots.txt. Один из вариантов, подходящий для служебных страниц, — запаролить ее. Бот не сможет просканировать содержимое страницы, если она доступна только пользователям, авторизованным через логин и пароль.

Если страницы нельзя закрыть паролем, но не хочется показывать их ботам, есть вариант применить директивы «noindex» и «nofollow». Для этого нужно добавить их в секцию HTML-кода страницы:

Чтобы робот правильно интерпретировал «noindex» и «nofollow» и не добавил страницу в индекс, не закрывайте одновременно доступ к ней в файле robots.txt. Так бот не получит доступа к странице и не увидит запрещающих директив.

Требования поисковых систем к файлу robots.txt

Каким должен быть файл, как его оформить и куда размещать — в этом и Яндекс, и Google солидарны:

Подробные рекомендации для robots.txt от Яндекса читайте здесь, от Google — здесь.

Дальше рассмотрим, каким образом можно давать рекомендации ботам.

Как правильно составить robots.txt

Файл состоит из списка команд (директив) с указанием страниц, на которые они распространяются, и адресатов — имён ботов, к которым команды относятся.

Директиву Clean-param воспринимают только боты Яндекса, а в остальном в 2021 году команды для ботов Google и Яндекса одинаковы.

Основные обозначения файла

User-agent — какой бот должен прореагировать на команду. После двоеточия указывают либо конкретного бота, либо обобщают всех с помощью символа *.

Пример. User-agent: * — все существующие роботы, User-agent: Googlebot — только бот Google.

Disallow — запрет сканирования. После косого слэша указывают, на что распространяется команда запрета.

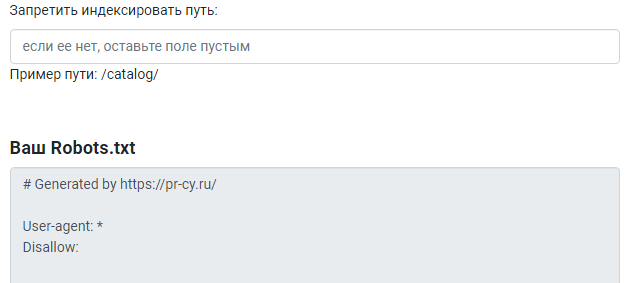

Пустое поле в Disallow означает разрешение на сканирование всего сайта:

А эта запись запрещает всем роботом сканировать весь сайт:

Если речь идет о новом сайте, проследите, чтобы в файле robots.txt не осталась эта запись, после того как разработчики выложат сайт на рабочий домен.

Эта запись разрешает сканирование боту Google, а всем остальным запрещает:

Отдельно прописывать разрешения необязательно. Доступным считается всё, что вы не закрыли.

В записях важен закрывающий косой слэш, его наличие или отсутствие меняет смысл:

Disallow: /about/ — запись закрывает раздел «О нас», доступный по ссылке https://example.com/about/

Disallow: /about — закрывает все ссылки, которые начинаются с «/about», включая раздел https://example.com/about/, страницу https://example.com/about/company/ и другие.

Каждому запрету соответствует своя строка, нельзя перечислить несколько правил сразу. Вот неправильный вариант записи:

Правильно оформить их раздельно, каждый с новой строки и своим Disallow:

Allow означает разрешение сканирования, с помощью этой команды удобно прописывать исключения. Для примера запись запрещает всем ботам сканировать весь альбом, но делает исключение для одного фото:

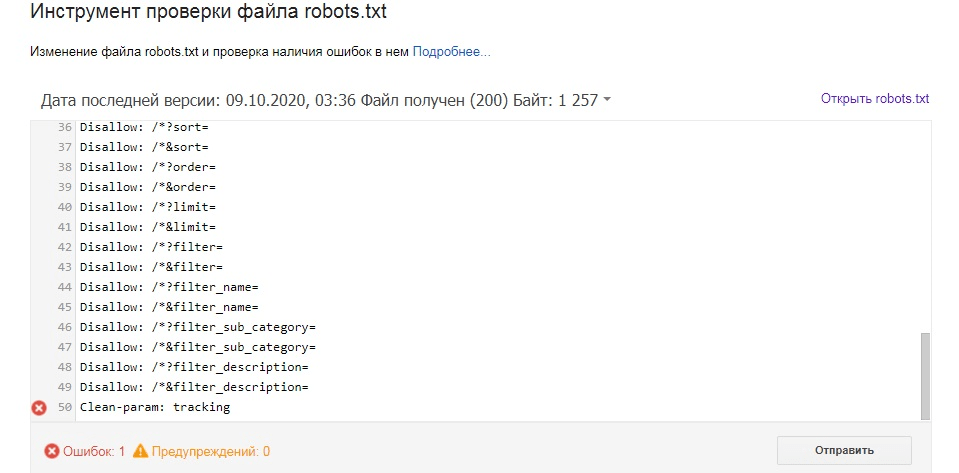

А вот и отдельная команда для Яндекса — Clean-param. Директиву используют, чтобы исключить дубли страниц, которые могут появляться из-за GET-параметров или UTM-меток. Clean-param распознают только боты Яндекса. Вместо нее можно использовать Disallow, эту команду понимают в том числе и гуглоботы.

Допустим, на сайте есть страница page=1 и у нее могут быть такие параметры:

Каждый образовавшийся адрес в индексе не нужен, достаточно, чтобы там была общая основная страница. В этом случае в robots нужно задать Clean-param и указать, что ссылки с дополнениями после «sid» в страницах на «/index.php» индексировать не нужно:

Clean-param: sid /index.php

Если параметров несколько, перечислите их через амперсанд:

Clean-param: sid&utm&ref /index.php

Строки не должны быть длиннее 500 символов. Такие длинные строки — редкость, но из-за перечисления параметров такое может случиться. Если указание получилось сложным и длинным, его можно разделить на несколько. Примеры найдете в Справке Яндекса.

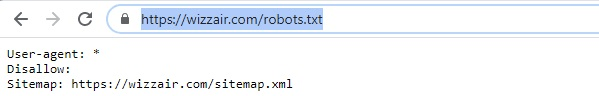

Sitemap — ссылка на карту сайта. Если карты сайта нет, запись не нужна. Сама по себе карта не обязательна, но если сайт большой, то лучше ее создать и дать ссылку в robots, чтобы ботам было проще разобраться в структуре.

Обозначим также два важных спецсимвола, которые используются в robots:

* — предполагает любую последовательность символов после этого знака;

$ — указывает на то, что на этом элементе необходимо остановиться.

Пример. Такая запись:

запрещает роботу индексировать страницу site.com/catalog/category1, но не запрещает индексировать страницу site.com/catalog/category1/product1.

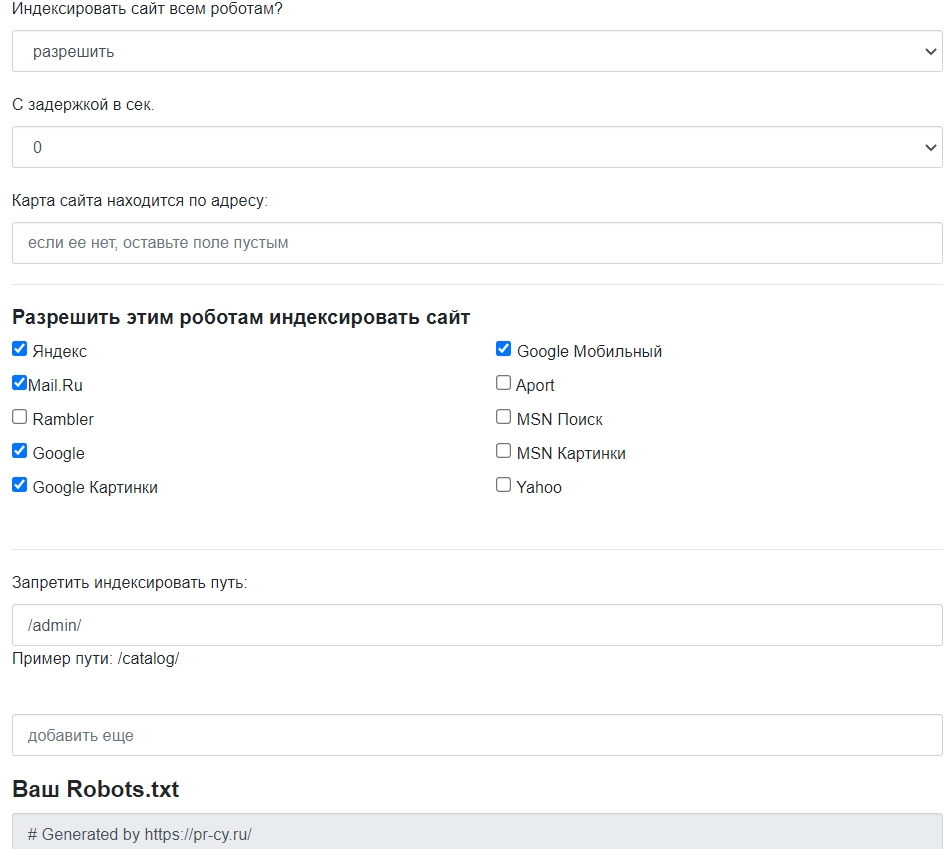

Лучше не заниматься сбором команд вручную, для этого есть сервисы, которые работают онлайн и бесплатно. Инструмент для генерации robots.txt бесплатно соберет нужные команды: открыть или закрыть сайт для ботов, указать путь к sitemap, настроить ограничение на посещение избранных страниц, установить задержку посещений.

Есть и другие бесплатные генераторы файла, которые позволят быстро создать robots и избежать ошибок. У популярных движков есть плагины, с ними собирать файл еще проще. О них расскажем ниже.

Как проверить правильность robots.txt

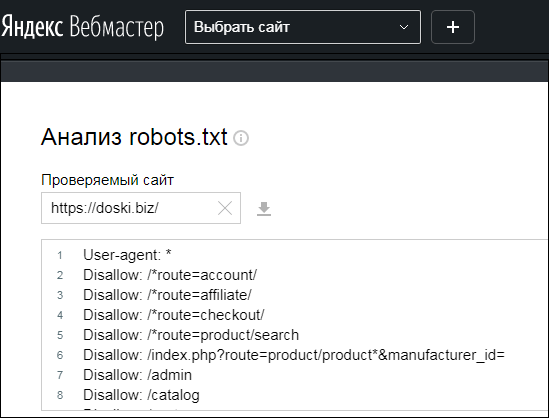

После создания файла и добавления в корневой каталог будет не лишним проверить, видят ли его боты и нет ли ошибок в записи. У поисковых систем есть свои инструменты:

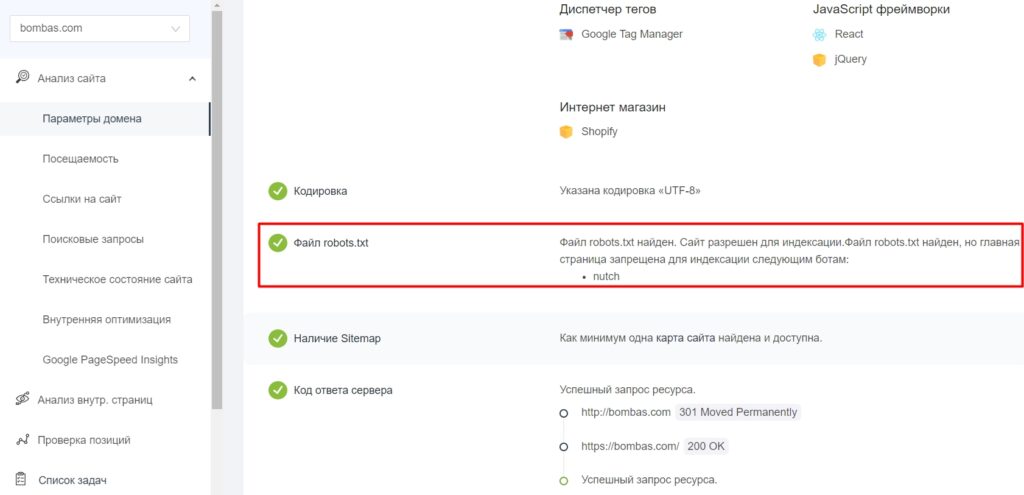

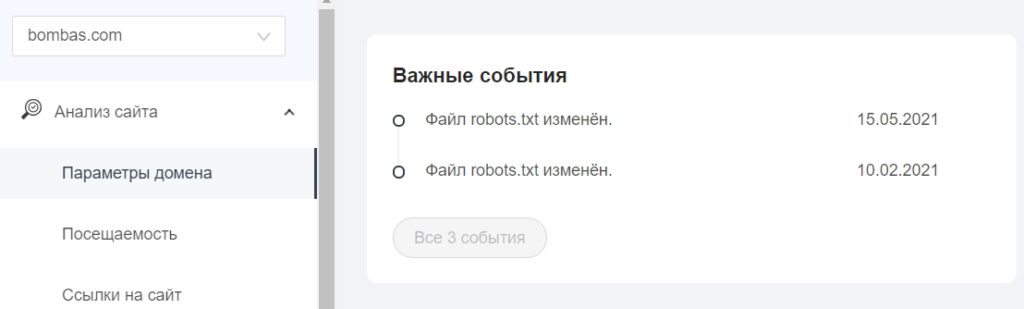

В «Важных событиях» отобразятся даты изменения файла.

Правильный robots.txt для разных CMS: примеры готового файла

Файл robots.txt находится в корневой папке сайта. Чтобы создать или редактировать его, нужно подключиться к сайту по FTP-доступу. Некоторые системы управления (например, Битрикс) предоставляют возможность редактировать файл в административной панели.

Посмотрим, какие возможности для редактирования файла есть в популярных CMS.

WordPress

У WP много бесплатных плагинов, которые формируют robots.txt. Эта опция предусмотрена в составе общих SEO-плагинов Yoast SEO и All in One SEO, но есть и отдельные, которые отвечают за создание и редактирование файла, например:

Пример robots.txt для контентного проекта на WordPress

Это вариант файла для блогов и других проектов без функции личного кабинета и корзины.

User-agent: * # установили общие правила для роботов

Disallow: /cgi-bin # закрыли системную папку, которая находится на хостинге

Disallow: /? # обобщили все параметры запроса на главной странице сайта

Disallow: /wp— # все специальные WordPress-файлы: /wp-json/, /wp-content/plugins, /wp-includes

Disallow: *?s= # здесь и далее перечисление запросов поиска

Disallow: */trackback # закрыли трекбеки — уведомления о появлении ссылки на статью

Disallow: */feed # новостные ленты полностью

Disallow: */rss # rss-ленты

Disallow: */embed # все встраивания

Disallow: /xmlrpc.php # файл API WP

Disallow: *utm*= # все ссылки, у которых прописаны UTM-метки

Disallow: *openstat= # все ссылки, у которых прописаны openstat-метки

Allow: */uploads # открыли доступ к папке с файлами uploads

Allow: /*/*.js # открыли доступ к js-скриптам внутри /wp-, уточнили /*/ для приоритета

Allow: /*/*.css # доступ к css-файлам внутри /wp-, также уточнили /*/ для приоритета

Allow: /wp-*.png # доступ к картинкам в плагинах, папке cache и других в формате png

Allow: /wp-*.jpg # то же самое для формата jpg

Allow: /wp-*.jpeg # для формата jpeg

Allow: /wp-*.gif # и для анимаций в gif

Allow: /wp-admin/admin-ajax.php # открыли доступ к этому файлу, чтобы не блокировать JS и CSS для плагинов

Sitemap: https://example.com/sitemap.xml # указали ссылку на карту сайта (вместо https://example.com нужно подставить сой домен)

Пример robots.txt для интернет-магазина на WordPress

Похожий файл, но со спецификой интернет-магазина на платформе WooCommerce на базе WordPress. Закрываем то же самое, что в предыдущем примере, плюс страницу корзины, а также отдельные страницы добавления в корзину и оформления заказа пользователем.

Продвинутое использование robots.txt без ошибок — руководство для SEO

1 сентября 2019 года Google прекратит поддержку нескольких директив в robots.txt. В список попали: noindex, crawl-delay и nofollow. Вместо них рекомендуется использовать:

404 и 410 коды ответа сервера. В ряде случаев, 410 отрабатывает значительно быстрей для удаления URL из индекса.

Защита паролем. Страницы, требующие авторизации, также обычно удаляются из индекса (важно — именно страницы, полностью скрытые под логином, а не часть контента).

Временное удаление страницы из индекса с помощью инструмента в Search Console.

Disallow в robots.txt.

Тем не менее, robots.txt по-прежнему остаётся одним из главных файлов для SEO-специалиста. Давайте вспомним самые полезные директивы от простых, до менее очевидных.

robots.txt

Это простой текстовый файл, который содержит инструкции для поисковых краулеров — какие страницы сайта не следует посещать, где лежит наш Sitemap.xml и для каких поисковых роботов распространяются правила.

Файл размещается в корневой директории сайта. Например:

Прежде чем начать сканирование сайта, краулеры проверяют наличие robots.txt и находят правила специфичные для их User-Agent, например Googlebot. Если таких нет — следуют общим инструкциям.

Действующие правила robots.txt

User-Agent

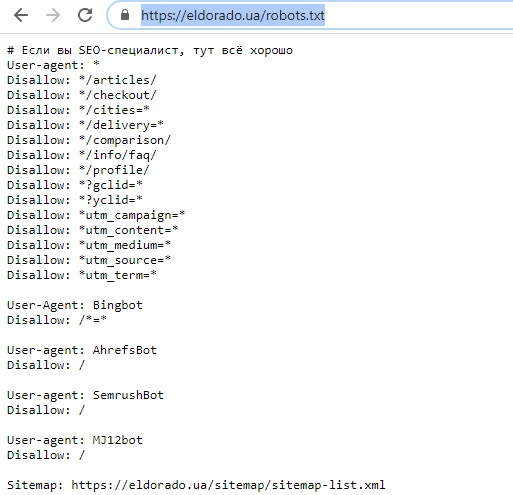

У каждой поисковой системы есть свои «агенты пользователя». По сути, это имя краулера, которое помогает дать определённые указания конкретному ему.

Если брать шире, то User-Agent — клиентское приложение на стороне поисковой системы, в некотором смысле имитирующее браузер или, например, мобильное устройство.

User-agent: * — символ астериск используются для обозначения сразу же всех краулеров.

User-agent: Yandex — основной краулер Яндекс-поиска.

User-agent: Google-Image — робот поиска Google по картинкам.

User-agent: AhrefsBot — краулер сервиса Ahrefs.

Важно: если в файле указаны правила для конкретных User-Agent, то роботы будут следовать только своим инструкциям, игнорируя общие правила.

Disallow

Директива, которая позволяет блокировать от индексации полностью весь сайт или определённые разделы.

Может быть полезно для закрытия от сканирования служебных, динамических или временных страниц (символ # отвечает за комментарии в коде и игнорируется краулерами).

Упростить инструкции помогают операторы:

* — любая последовательность символов в URL. По умолчанию к концу каждого правила, описанного в файле robots.txt, приписывается спецсимвол *.

$ — символ в конце URL-адреса, он используется чтобы отменить использование * на конце правила.

Важно: в robots.txt не нужно закрывать JS и CSS-файлы, они понадобятся поисковым роботом для правильного отображения (рендеринга) контента.

Allow

С помощью этой директивы можно, напротив, разрешить каталог или конкретный адрес к индексации. В некоторых случаях проще запретить к сканированию весь сайт и с помощью Allow открыть нужные разделы.

Также Allow можно использовать для отдельных User-Agent.

Crawl-delay

Директива, теряющая актуальность в случае Goolge, но полезная для работы с другими поисковиками.

Позволяет замедлить сканирование, если сервер бывает перегружен. Устанавливает интервал времени для обхода страниц в секундах (для Яндекса). Чем выше значение, тем медленнее краулер ходит по сайту.

Несмотря на то, что Googlebot игнорирует подобные правила, настроить скорость сканирования можно в Google Search Console проекта.

Интересно, что китайский Baidu также не обращает внимание на Crawl-delay в robots.txt, а Bing воспринимает команду как «временное окно», в рамках которого BingBot будет сканировать сайт только один раз.

Важно: если установлено высокое значение Crawl-delay, убедитесь, что ваш сайт своевременно индексируется. В сутках 86 400 секунд, при Crawl-delay: 30 будет просканировано не более 2880 страниц в день, что мало для крупных сайтов.

Sitemap

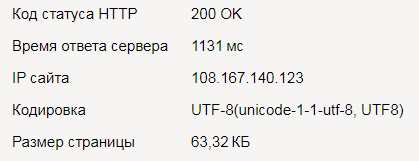

Одно из ключевых применений robots.txt в SEO — указание на расположение карты сайты. Обратите внимание, используется полный URL-адрес (их может быть несколько).

Нужно иметь в виду:

Директива Sitemap указывается с заглавной S.

Sitemap не зависит от инструкций User-Agent.

Нельзя использовать относительный адрес карты сайта, только полный URL.

Файл XML-карты сайта должен располагаться на том же домене.

Также убедитесь, что ссылка возвращает статус 200 OK без редиректов. Проверить можно с помощью инструмента, определяющего ответ сервера или анализа XML-карты сайта.

Типичный robots.txt

Ниже представлены простые и распространенные шаблоны команд для поисковых роботов.

Разрешить полный доступ

Обратите внимание, правило для Disallow в этом случае не заполняется.

Полная блокировка доступа к хосту

Запрет конкретного раздела сайта

Запрет сканирования определенного файла

Распространенная ошибка

Установка индивидуальных правил для User-Agent без дублирования инструкций Disallow.

Как мы уже выяснили, при указании директивы User-Agent, соответствующий краулер будет следовать только тем правилам, что установлены именно для него. Не забывайте дублировать общие директивы для всех User-Agent.

В примере ниже — слегка измененный robots.txt сайта IMDB. Общие правила Disallow не будут распространяться на бот ScoutJet. А вот Crawl-delay, напротив, установлена только для него.

Противоречия директив

Список распространенных User-Agent

| User-Agent | # |

|---|---|

| Googlebot | Основной краулер Google |

| Googlebot-Image | Робот поиска по картинкам |

| Bing | |

| Bingbot | Основной краулер Bing |

| MSNBot | Старый, но всё ещё использующийся краулер Bing |

| MSNBot-Media | Краулер Bing для изображений |

| BingPreview | Отдельный краулер Bing для Snapshot-изображений |

| Яндекс | |

| YandexBot | Основной индексирующий бот Яндекса |

| YandexImages | Бот Яндеса для поиска по изображениям |

| Baidu | |

| Baiduspider | Главный поисковый робот Baidu |

| Baiduspider-image | Бот Baidu для картинок |

| Applebot | Краулер для Apple. Используется для Siri поиска и Spotlight |

| SEO-инструменты | |

| AhrefsBot | Краулер сервиса Ahrefs |

| MJ12Bot | Краулер сервиса Majestic |

| rogerbot | Краулер сервиса MOZ |

| PixelTools | Краулер «Пиксель Тулс» |

| Другое | |

| DuckDuckBot | Бот поисковой системы DuckDuckGo |

Советы по использованию операторов

1. Заблокировать определённые типы файлов.

Этот приём активно используется, если у проекта настроено ЧПУ для всех страниц и документы с GET-параметрами точно являются дублями.

Заблокировать результаты поиска, но не саму страницу поиска.

Имеет ли значение регистр?

Определённо да. При указании правил Disallow / Allow, URL адреса могут быть относительными, но обязаны сохранять регистр.

Но сами директивы могут объявляться как с заглавной, так и с прописной: Disallow: или disallow: — без разницы. Исключение — Sitemap: всегда указывается с заглавной.

Как проверить robots.txt?

Есть множество сервисов проверки корректности файлов robots.txt, но, пожалуй, самые надёжные: Google Search Console и Яндекс.Вебмастер.

Для мониторинга изменений, как всегда, незаменим «Модуль ведения проектов»:

Контроль индексации на вкладке «Аудит» — динамика сканирования страниц сайта в Яндексе и Google.

Оптимальный robots.txt

Казалось бы, такая очевидная вещь — составить robots.txt, однако количество ошибок при этом зашкаливает:(

Попробуем разобраться с основными моментами.

1. Что такое файл robots.txt

Robots.txt — текстовый файл, расположенный на сайте, который предназначен для роботов поисковых систем. В этом файле веб-мастер может указать параметры индексирования своего сайта как для всех роботов сразу, так и для каждой поисковой системы по отдельности.

Каждый по своему понимает это определение, однако важно вынести для себя всего одну мысль — это набор правил по которым поисковый робот не будет индексировать указанный раздел или страницу сайта. Не нужно писать в нем лишнего, достаточно ограничится именно тем набором правил который нужен именно для вашего сайта.

2. Указываем User-agent

С помощью директивы User-agent мы указываем к какому именно поисковому роботу мы обращаемся своим набором правил. Эта директива позволяет создать уникальные правила под робота Яндекса, Гугла и прочих поисковиков.

Данная директива обязательна, без нее ваш robots.txt будет считаться некорректным и все правила в нем будут проигнорированы.

В качестве примера будем писать универсальный robots.txt для всех поисковиков.

Таким образом мы обратились ко всем поисковым ботам зашедшим к нам на сайт. Для обращения к конкретному боту — надо указывать его имя

Полный список поисковых роботов можно посмотреть здесь

Для более плотной работы с конкретным поисковиком, нужно изучить полный список роботов представленных в справке поисковика. Например Яндекс дает следующий список роботов:

‘YandexBot’ — основной индексирующий робот;

‘YandexMedia’ — робот, индексирующий мультимедийные данные;

‘YandexImages’ — индексатор Яндекс.Картинок;

‘YandexCatalog’ — «простукивалка» Яндекс.Каталога;

‘YandexDirect’ — робот, индексирующий страницы сайтов, участвующих в Рекламной сети Яндекса;

‘YandexBlogs’ — робот поиска по блогам, индексирующий комментарии постов;

‘YandexNews’ — робот Яндекс.Новостей;

‘YandexPagechecker’ — робот, обращающийся к странице при валидации микроразметки через форму «Валидатор микроразметки»;

Важно: Персональное обращение к роботу имеет больший приоритет чем общее и оно будет проигнорированно:

Правила указанные для

Таким образом мы можем составлять правила для игнорирования отдельных разделов сайта, но позволяющие индексировать внутри них определенную часть контента.

Мы запретили всем роботам индексировать Галерею, но роботу Яндекс.Картинок разрешили индексировать картинки в этом разделе сайта.

3. Указываем главное зеркало сайта. Директива Host

Мы разобрали что писать в начале файла robots.txt, теперь посмотрим что написать в конце. Директива Host нужна для указания главного зеркала сайта. Каждый сайт доступен как минимум по двум адресам с www и без www.

Определимся какой из урлов у нас будет главным (допустим с www) и запишем его:

Таким образом получили минимально необходимый robots.txt

Директива Host работает только для Яндекса. Гугл сам вполне корректно определяет главное зеркало сайта. Удачным решением будет добавить сайт в панель вебмастера в Гугле и в Яндексе и продублировать там эту информацию.

Когда мы указали главное зеркало сайта, мы подразумеваем что все ссылки на сайте формируются в соответствии с главным зеркалом сайта, однако пользователи на сторонних ресурсах могут ссылаться на ваш домен без www. В результате мы теряем часть ссылочной массы: это и ТИЦ, и ПР, и ссылочное.

самый простой способ — это 301 редирект через htaccess

301 редирект сообщает поисковому роботу что страница постоянно перемещена по следующему адресу. В результате мы не теряем ссылочное и пользователь перешедший по неправильному адресу автоматически переадресуется на правильный.

4. Запрещаем и Разрешаем индексацию. Директивы Allow и Disallow

Основные ошибки происходят в этой части, центральной, файла robots.txt

Запретить то что не нужно запрещать😊Прежде чем приступать к написанию правил — важно четко понять одну простую вещь, робот видит сайт глазами незарегистрированного посетителя. Проанализируйте (разлогинившись) ваш сайт на предмет ссылок на системные папки и страницы генерируемые под залогиненого пользователя. Очевидно же что бот не может знать структуру системных папок на вашем сервере без доступа к фтп, поэтому запрещать ему доступ к системным папкам незачем. На них нет ссылок с сайта, а если есть, то лучше их убрать 🙂

Таким образом мы исключаем из запрета к индексации ссылки на добавление статьи, записи в блог, объявления, добавления фото и тд. То есть все те ссылки которые может увидеть только авторизованный человек.

Итого из этого длинного списка, по делу оказалось лишь 3 строчки, остальное бесполезно и местами даже опасно (раскрытие путей к дампам базы данных, к админке и системным каталогам)

Пока закончим на основах, что бы было понимание того что делаем и почему так. В следующий раз будем разбирать дубликаты страниц и как их удалить из выдачи.

Для чего нужен файл robots.txt? Как его настроить и проверить

Файл robots.txt — это текстовый документ в корневом каталоге сайта с информацией для поисковых роботов о том, какие URL (на которых расположены страницы, файлы, папки, прочее) стоит сканировать, а какие — нет. Наличие этого файла не является обязательным условием для работы ресурса, но в то же время правильное его заполнение лежит в основе SEO.

Решение об использовании robots.txt было принято еще в 1994 году в рамках «Стандарта исключений для роботов». Согласно справке Google, файл предназначен не для запрета показа веб-страниц в результатах поиска, а для ограничения количества запросов роботов к сайту и снижения нагрузки на сервер.

В целом содержимое robots.txt стоит отнести к разряду рекомендаций поисковым ботам, задающих правила сканирования страниц сайта. Чтобы увидеть содержимое robots.txt на любом сайте, нужно добавить к имени домена в браузере /robots.txt.

Для чего используют robots.txt?

К основным функциям документа можно отнести закрытие от сканирования страниц и файлов ресурса в целях рационального расхода краулингового бюджета. Чаще всего закрывают информацию, которая не несет ценности для пользователя и не влияет на позиции сайта в поиске.

| Примечание. Краулинговый бюджет — количество страниц сайта, которое может просканировать поисковый робот. Для его экономии стоит направлять робота только к самому важному содержимому ресурса, закрывая доступ к малополезной информации. |

Какие страницы и файлы закрывают с помощью robots.txt

1. Страницы с персональными данными.

Это могут быть имена и телефоны, которые посетители указывают при регистрации, страницы личного кабинета, номера платежных карт. В целях безопасности доступ к этой информации стоит дополнительно защищать паролем.

2. Вспомогательные страницы, которые появляются только при определенных действиях пользователя.

К ним можно отнести сообщения об успешно оформленном заказе, клиентские формы, страницы авторизации или восстановления пароля.

3. Админпанель и системные файлы.

Внутренние и служебные файлы, с которыми взаимодействует администратор сайта или вебмастер.

4. Страницы поиска и сортировки.

На страницы, которые отображаются по запросу, указанному в окне поиска на сайте, как правило, ставят запрет сканирования. Это же относится к результатам сортировки товаров по цене, рейтингу и другим критериям. Исключением могут быть сайты-агрегаторы.

5. Страницы фильтров.

Результаты, которые отображаются после применения фильтров (размер, цвет, производитель и т.д.), являются отдельными страницами и могут быть расценены как дубли контента. SEO-специалисты, как правило, ограничивают их сканирование, за исключением ситуаций, когда они приносят трафик по брендовым и другим целевым запросам.

6. Файлы определенного формата.

К ним могут относиться фото, видео, PDF-документы, JS-скрипты. С помощью robots.txt можно ограничивать сканирование файлов как по отдельности, так и по определенному расширению.

Как создать и где разместить robots.txt?

Инструменты для настройки robots txt

Также можно использовать генератор robots.txt. Некоторые сайты предоставляют бесплатные инструменты создания на основании заданных вами условий.

Название и размер документа

Имя файла robots.txt должно выглядеть именно так, без использования заглавных букв. Допустимый размер документа согласно рекомендациям Google и Яндекса — 500 КиБ. При превышении лимита робот может обработать документ частично, воспринять как полный запрет сканирования или, наоборот, пройтись по всему содержимому ресурса.

Где разместить файл

Документ находится в корневом каталоге на хостинге и доступ к нему возможен через FTP. Перед внесением изменений рекомендуется сначала скачать robots.txt в исходном виде.

Синтаксис и директивы robots.txt

Теперь разберем синтаксис robots.txt, состоящий из директив (правил), параметров (страниц, файлов, каталогов) и специальных символов, а также функции, которые они выполняют.

Общие требования к содержимому файла

1. Каждая директива должна начинаться с новой строки и формироваться по принципу: одна строка = одна директива + один параметр.